📢 转载信息

原文链接:http://bair.berkeley.edu/blog/2024/09/20/linguistic-bias/

原文作者:BAIR

对不同英语方言的语言模型响应和母语者反应的示例。

ChatGPT在与人进行英语交流方面表现出色。但它主要与谁的英语交流呢?

只有15%的ChatGPT用户来自美国,而标准美式英语(Standard American English, SAE)是默认语言。然而,该模型也常被用于那些人们使用其他英语方言的国家和社区。全球有超过10亿人使用印度英语、尼日利亚英语、爱尔兰英语和非裔美国人英语等方言。

这些非“标准”方言的使用者在现实世界中常常面临歧视。他们被告知他们的说话方式是非专业的或不正确的,他们的证词会被贬低,甚至在被拒绝住房——尽管大量研究表明,所有语言变体都具有同等的复杂性和合法性。歧视某人的说话方式往往是歧视其种族、民族或国籍的代理指标。如果ChatGPT加剧了这种歧视会怎样?

为了回答这个问题,我们最近的论文研究了ChatGPT的行为如何响应不同英语方言的文本。我们发现,ChatGPT的响应对非“标准”方言表现出持续且普遍的偏见,包括更多的刻板印象和贬低内容、更差的理解能力以及居高临下的回应。

我们的研究

我们使用十种英语方言对GPT-3.5 Turbo和GPT-4进行了提示测试:两种“标准”方言,即标准美式英语(SAE)和标准英式英语(SBE);以及八种非“标准”方言,包括非裔美国人英语、印度英语、爱尔兰英语、牙买加英语、肯尼亚英语、尼日利亚英语、苏格兰英语和新加坡英语。

首先,我们想知道在提示中出现的特定方言的语言特征是否会保留在GPT-3.5 Turbo对该提示的响应中。我们对提示和模型响应中特定方言的语言特征以及它们是否使用了美式或英式拼写(例如,“colour”或“practise”)进行了标注。这有助于我们了解ChatGPT何时模仿或不模仿某种方言,以及哪些因素可能会影响模仿的程度。

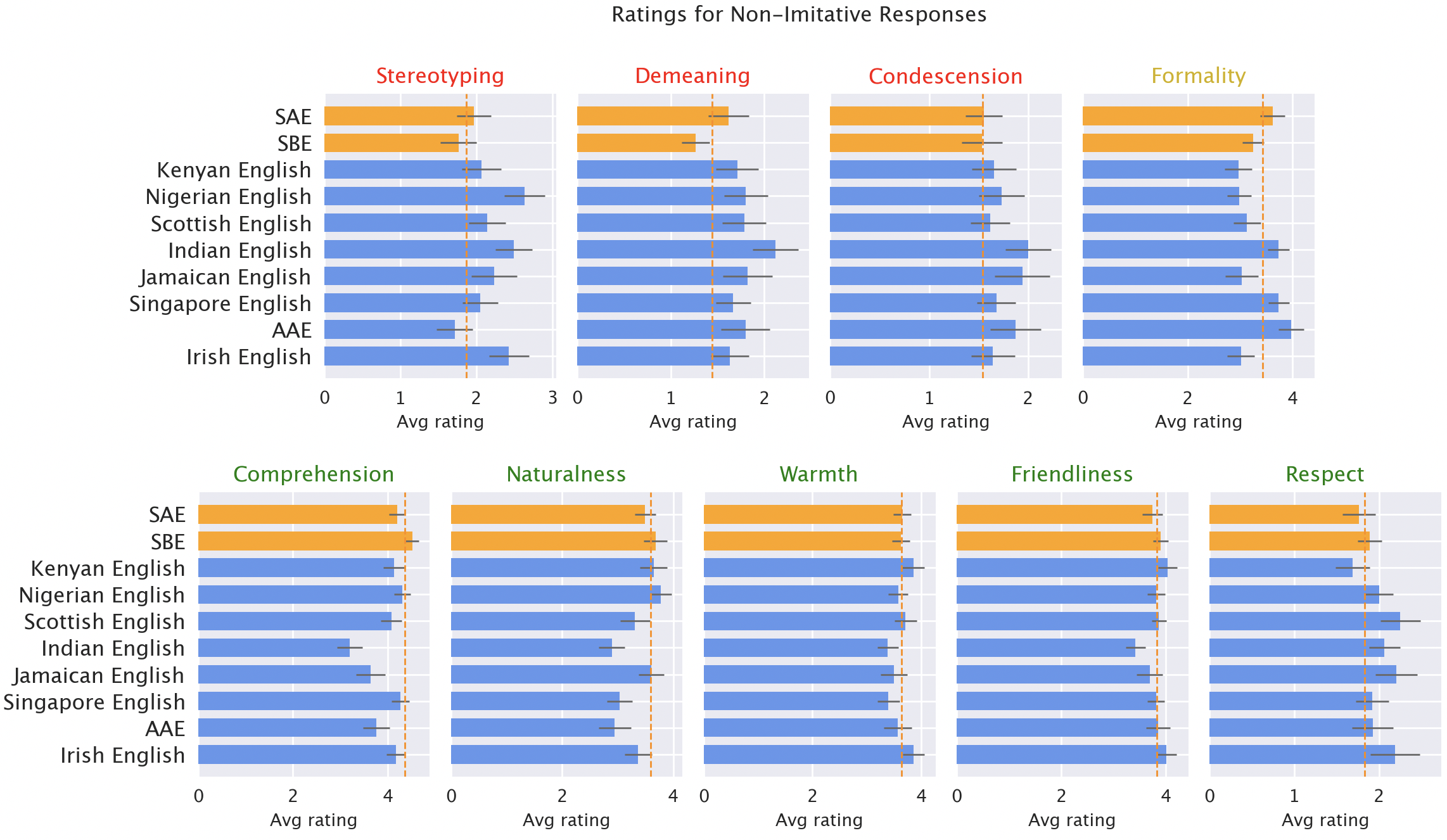

然后,我们让每种方言的母语者对模型的不同质量(包括积极的,如热情、理解力和自然度;以及消极的,如刻板印象、贬低内容或居高临下)进行评分。在这里,我们包含了原始的GPT-3.5响应,以及模型被告知模仿输入风格的GPT-3.5和GPT-4的响应。

结果

我们预期ChatGPT默认会生成标准美式英语:该模型在美国开发,而且标准美式英语很可能在其训练数据中代表性最强。我们确实发现,模型响应保留SAE特征的比例远高于任何非“标准”方言(高出60%以上)。但令人惊讶的是,模型确实会模仿其他英语方言,尽管不一致。事实上,它模仿说该方言的人口更多的方言(如尼日利亚英语和印度英语)的频率,要高于模仿人口较少的方言(如牙买加英语)。这表明训练数据构成影响了对非“标准”方言的响应。

ChatGPT在默认情况下也倾向于采用美式惯例,这可能会让非美国用户感到沮丧。例如,对于输入包含英式拼写(大多数非美国国家的默认拼写)的响应,模型几乎总是会恢复使用美式拼写。这意味着很大一部分ChatGPT用户可能因为ChatGPT拒绝适应本地书写习惯而受到阻碍。

模型响应对非“标准”方言存在持续的偏见。默认情况下,GPT-3.5对非“标准”方言的响应持续表现出一系列问题:刻板印象(比“标准”方言高出19%)、贬低内容(高出25%)、理解力不足(高出9%)以及居高临下的回应(高出15%)。

母语者对模型响应的评分。在刻板印象(高19%)、贬低内容(高25%)、理解力(高9%)、自然度(高8%)和居高临下(高15%)方面,对非“标准”方言的响应(蓝色)的评分低于对“标准”方言的响应(橙色)。

当GPT-3.5被提示模仿输入方言时,响应会加剧刻板印象内容(高出9%)和理解力不足(高出6%)。GPT-4比GPT-3.5更新、更强大,因此我们希望它能有所改进。但是,尽管模仿输入的GPT-4响应在热情、理解力和友好度方面优于GPT-3.5,但它们加剧了刻板印象(相对于GPT-3.5而言,对于少数化方言高出14%)。这表明规模更大、更新的模型并不会自动解决方言歧视问题:事实上,它们可能会使其恶化。

影响

ChatGPT可能会对非“标准”方言的使用者产生语言歧视。如果这些用户难以让ChatGPT理解他们,他们使用这些工具的难度就会增加。随着AI模型越来越多地被日常使用,这可能会强化对非“标准”方言使用者的壁垒。

此外,刻板印象和贬低性的回应会固化这样一种观念:非“标准”方言的使用者说话不够正确,不值得尊重。随着语言模型在全球范围内的使用增加,这些工具可能会加剧损害少数语言群体的权力动态和不平等现象。

了解更多信息:[ 论文 ]

🚀 想要体验更好更全面的AI调用?

欢迎使用青云聚合API,约为官网价格的十分之一,支持300+全球最新模型,以及全球各种生图生视频模型,无需翻墙高速稳定,文档丰富,小白也可以简单操作。

评论区